1. A100算力分析

英伟达A100显卡基于安培架构,拥有高达10496个CUDA核心,显存容量为40GB或80GB HBM2,带宽达到612GB/s。A100支持多种AI应用,如深度学习、科学计算等,具备强大的算力。

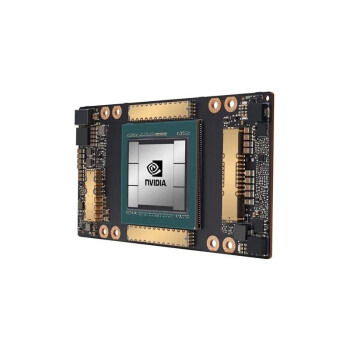

2. V100算力分析

英伟达V100显卡基于特斯拉架构,拥有8096个CUDA核心,显存容量为32GB HBM2,带宽达到900GB/s。V100同样适用于深度学习、科学计算等领域,算力表现也不俗。

二、A100与V100适用场景对比

了解了A100与V100的算力差异后,我们来分析一下它们在哪些场景中更为适用。

1. A100适用场景

A100显卡在数据中心、高性能计算、AI训练等领域表现出色,尤其适用于需要大量并行计算和高速显存带宽的应用。

2. V100适用场景

V100显卡在AI推理、深度学习、科学计算等领域具有较高的性能,适合对显存容量和带宽有一定需求的场景。

三、如何选择A100与V100显卡

在选择A100与V100显卡时,用户需根据自身需求、预算等因素进行权衡。

1. 需求分析

如果您的应用场景对显存容量和带宽有较高要求,如数据中心、高性能计算等,那么A100显卡可能更适合您。

2. 预算考虑

如果您的预算相对有限,或者对显存容量和带宽需求不是特别高,那么V100显卡也是一个不错的选择。

如何为AI算力需求选择合适的GPU显卡?在选择GPU显卡时,用户需要考虑以下几个因素:应用场景、预算、显存容量、带宽、CUDA核心数量等。针对AI算力需求,可以选择A100或V100显卡。此外,还可以关注其他品牌的高性能显卡,如AMD的Radeon Instinct系列等。

A100与V100显卡在算力上各有优势,用户需根据自身需求和应用场景进行选择。道通存储作为专业的GPU供应商,为您提供可靠、有现货的GPU显卡,助力我国AI产业发展。