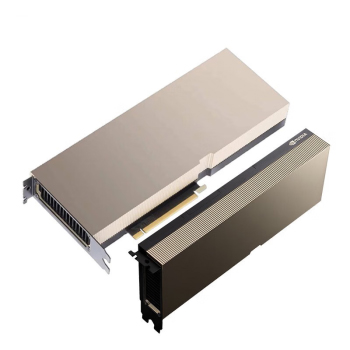

最近不少客户在问H200的功耗问题呐。这块新卡用的可是NV最新的Hopper架构,标称TDP 700W,但是是实际运行哪有这么简单呀。

咱们得看具体应用场景。跑AI训练时,动态功耗能冲到750W左右,要是开了液冷超频,破800W也不稀奇。不过嘛,NVIDIA这回的功耗墙设计挺聪明,待机状态下能自动降到150W以下。

显存配置才是真亮点

别看功耗高了点,

HBM3显存带来的优势可太明显了。141GB的超大容量,配着4.8TB/s的恐怖带宽,比A100整整翻了两倍多。做千亿参数大模型的朋友应该懂,显存够大才能避免频繁掉算力啊。

对了,最近有客户拿它和H100比功耗。说实话两款卡的TDP相差不到5%,但是是H200的每瓦算力提升了15%,这买卖划算不?

散热方案要跟上

现在深圳这边现货价徘徊在230万上下,买整机的话强烈建议选液冷方案。我们已经碰到好几起因风冷压不住,导致算力波动的案例了。毕竟700W的持续输出,可不是普通散热能搞定的。

说到采购策略,最近海关数据挺有意思。Q3季度H系列的进口量涨了30%,但是是价格反而降了8个百分点。要是企业不急用,等等党可能还能再蹲蹲看。

H200在沪苏杭那边特别吃香,主要是做自动驾驶模型的团队在抢。他们测试下来,同样参数规模下训练时间能节省20%,电费开支倒是跟H100差不多。

买卡避坑指南

提醒各位注意看SN码!上个月华东区查到批水货卡,PCB印刷都有重影。现在正规渠道拿货周期大概6-8周,现货价格虚高的要当心。

最后说个实测数据吧。我们用PyTorch跑1750亿参数模型时,

单卡H200的持续功耗稳定在720W左右。比起老黄发布会上说的数值,其实还保守了点儿呢。