AI算力需求的爆发式增长使得英伟达显卡成为业界焦点,尤其是A100、H100等专业计算卡与4090等消费级旗舰的供需动态牵动无数采购商神经。针对当前我国市场最关注的英伟达显卡性能排序问题,我们结合最新测试数据和实际应用场景,剖析不同型号的核心优势与适用领域。

一、英伟达显卡性能排名与关键差异

在专业计算领域,H200以4.8TB/s的超高带宽和141GB的HBM3显存位居榜首,单精度浮点性能达1979 TFLOPS,主要面向大型语言模型训练。H100紧随其后,其Transformer引擎可加速LLM训练速度3倍,售价约220万元。定位中端的A100与A800均配备40GB HBM2显存,但A800的NVLink带宽被限制在400GB/s,更适合普通数据中心部署。

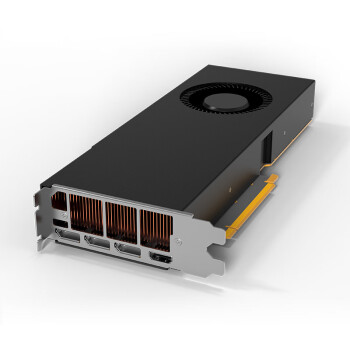

消费级显卡中,RTX 4090以16384个CUDA核心和24GB GDDR6X显存领跑,1.9万元的售价提供83 TFLOPS算力,是性价比最高的AI推理卡。值得注意的是,涡轮版的4090更适合机架式部署,其散热设计允许密集安装。

二、如何选择适合AI训练的英伟达显卡?

大模型训练首选H200或H100,二者的FB32运算模式可提升矩阵计算效率5倍。中小型企业可考虑租赁A100集群,单卡15万的价格配合NVLink实现多卡并联时,8卡系统可提供5PetaFLOPS的算力。推理场景下,4张4090组成的系统成本仅7万元,却能提供330TFLOPS算力,特别适合Stable Diffusion等生成式AI应用。

具体选择时需关注三个指标:首先检查显存带宽,H200的4.8TB/s比A100高2.3倍;其次对比TF32精度性能,H100在此模式下达989TFLOPS;最后考虑电源需求,H200需配置1200W以上电源。

三、英伟达显卡的现货采购策略

目前H100等高端卡的供货周期普遍在3个月以上,部分渠道现货需加价30%。正规代理渠道的A100库存相对充足,但需提供最终用户承诺书。对于急需部署的企业,考虑采用4090临时方案,其24GB显存可承载70亿参数模型。

采购时务必验证三项凭证:官网可查的SN码、代理授权证书、原厂静电袋封装。警惕所谓"行业定制版",这类产品往往阉割了关键计算单元。

四、实战中的配置优化方案

双路H100服务器配置推荐采用英特尔至强8462Y处理器,搭配1TB DDR5内存,通过NVSwitch实现300GB/s的卡间互联。散热需采用液冷方案,每台机柜功耗控制在42kW以内。对于使用4090搭建推理集群的情况,建议选用超微4029GP-TRT机箱,支持8卡全高全长的部署,需配合2000W铂金电源。

软件层面需注意:CUDA 12.4对H200有新优化,TensorRT 9.3可提升4090的INT8推理性能40%。在Ubuntu 22.04系统下,需手动安装dkms驱动才能启用全部计算单元。