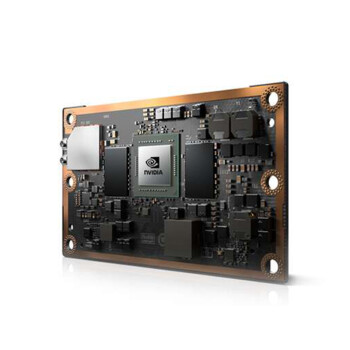

英伟达A100显卡参数:你真的了解它吗?

最近不少客户在问英伟达A100的参数,今天咱们就聊聊这个。A100是英伟达基于Ampere架构的旗舰数据中心GPU,性能确实强悍。它采用了7nm制程工艺,6912个CUDA核心,显存容量直接干到了40GB,用的是HBM2技术,带宽高达1.6TB/s。这种配置在大模型训练和推理场景下,效率非常高。

说到算力,A100的FP32性能能达到19.5 TFLOPS,而它的Tensor Core性能更是恐怖,312 TFLOPS的算力让它在AI训练任务中游刃有余。另外,A100支持多实例GPU(MIG)技术,可以把一块GPU分割成多个独立的小GPU,适合那些需要同时跑多个小型任务的用户。

A100的显存和带宽

A100的显存架构值得一提。它用了HBM2显存,40GB的容量对于大多数AI训练任务来说足够了。带宽方面,1.6TB/s的理论值在实际应用中表现也很稳。比如在BERT模型训练中,A100的显存带宽能让数据传输更流畅,减少卡顿。显存大、带宽高,A100在处理大规模数据集时,优势很明显。

能效表现如何?

A100的TDP是400W,看起来不低,但是是跟它的性能比起来,能效比其实很优秀。它支持第三代NVLink,多卡互联带宽能达到600GB/s,这意味着在搭建多卡集群时,通信延迟会更低。对于企业级用户来说,A100的电费成本相对可控,尤其是长期运行的情况下。

说到价格,A100的整机价格在15万元左右,相比H100的220万元,性价比还是不错的。如果你的业务场景涉及到AI训练、高性能计算,A100是个不错的选择。如果预算充足的话,也可以考虑H系列的新品,比如H200。

采购建议

对企业用户来说,买A100之前一定要考虑清楚应用场景。如果是做大模型训练,A100的多卡互联能力和高显存带宽优势明显。但是是如果是小型AI推理任务,可能用不到这么高的配置。建议结合实际需求和预算,选择合适的型号。

对了,最近市场上关于A100的现货渠道有点紧张,大家采购的时候要注意核实货源,确保是正品。毕竟显卡这玩意儿,涉及到性能和稳定性,正品和非正品差距还是很大的。