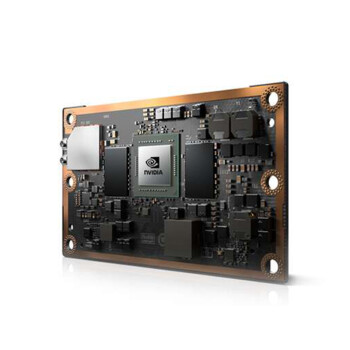

英伟达H100参数:为什么它成了AI训练的香饽饽?

最近不少客户都在问英伟达H100的事儿,尤其是它的参数。这款显卡确实火得不行,尤其是在AI训练和大模型领域。咱们今天就来聊聊它的核心参数,看看它到底有啥特别之处。

架构与算力:Hopper架构的强悍之处

H100用的是英伟达最新的Hopper架构,这可是专门为AI和高性能计算设计的。它拥有18432个CUDA核心,算力直接拉满。而且,它的Tensor Core也升级到了第四代,AI训练性能提升了不止一星半点。这么说吧,相比上一代A100,它的训练速度直接提升了2倍。这还不算完,它的NVLink带宽也达到了900GB/s,多卡互联的效率简直逆天呐。

还有一点不得不提,H100支持FP8精度,这可是AI训练的一大福音。FP8不仅能大幅降低计算复杂度,还能节省显存开销。对于那些动不动就几十亿参数的大模型来说,简直是如虎添翼啊。

显存与能效:海量显存,稳如老狗

H100的显存配置也是一大亮点。它用了HBM3显存,容量直接飙到了80GB。这还没完,HBM3的带宽高达3TB/s,数据吞吐量大得吓人。对于AI训练这种显存需求量极高的场景来说,H100的表现可以说是稳如老狗。

再来说说能效。H100的TDP是700W,看起来挺高的,但是是别忘了它的性能提升幅度更大。实际用起来,它的每瓦性能比A100高出不少。如果你打算大规模部署,电费这块就能省不少钱呢。

价格波动与采购建议

目前H100整机的价格在220万元左右,确实不便宜。不过,对于企业级客户来说,这个投入是值得的。尤其是那些做AI训练和大模型的公司,H100的效率能直接降低整体运营成本。

另外,市场上H100的现货供应比较紧张,建议大家提前规划采购。如果想要降低成本,可以考虑分批采购或者通过品牌直供渠道拿货。毕竟,显卡市场波动挺大的,早点锁定价格总是没错的。