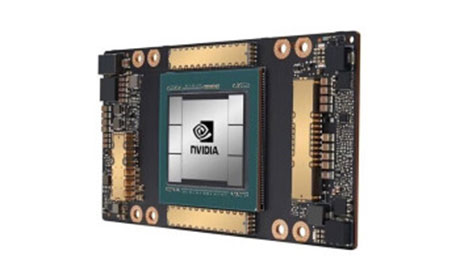

NVIDIA A100,高性能计算与AI领域的旗舰级加速卡

概述:NVIDIA A100作为一款由英伟达推出的旗舰级加速卡,凭借其卓越的计算性能和创新技术架构,成为高性能计算(HPC)与人工智能(AI)领域的核心硬件支撑。本文将从技术架构、应用场景、核心优势等方面,...

NVIDIA A100的核心技术架构解析

NVIDIA A100基于英伟达全新的安培(Ampere)GPU架构,在硬件设计上实现了多维度突破。其搭载了5424个CUDA核心,核心频率高达1.41GHz,单精度浮点运算性能(FP32)达到19.5 TFLOPS,双精度浮点运算性能(FP64)为9.7 TFLOPS,相比上一代P100提升了约20倍,为复杂计算任务提供了强大算力基础。

在显存配置方面,A100配备了HBM2e高带宽显存,单卡显存容量最高达80GB,显存带宽达到2TB/s,有效解决了大模型训练和科学计算中的数据吞吐瓶颈。A100集成了第三代Tensor Core和Transformer Engine,前者通过混合精度计算(FP16/FP8)将AI训练效率提升4倍,后者则针对Transformer架构的大语言模型优化,使NLP任务的推理速度提升20倍。

NVIDIA A100在关键领域的应用表现

在高性能计算领域,NVIDIA A100广泛应用于气候模拟、基因测序、工程仿真等场景。,在气候模型预测中,A100可通过并行计算快速处理海量气象数据,将原本需要数周的模拟周期缩短至几天;在基因分析领域,其强大的算力支持可加速DNA序列比对和蛋白质结构预测,推动精准医疗的发展。

在人工智能领域,A100更是大语言模型训练的“标配”硬件。从早期的GPT-3到如今的GPT-

4、LLaMA等模型,A100凭借高显存和高算力,支撑了数十亿参数模型的高效训练。同时,在计算机视觉任务中,A100可实时处理4K/8K视频流,在图像识别、目标检测等场景中实现低延迟推理,为自动驾驶、安防监控等应用提供技术保障。

NVIDIA A100的行业影响力与市场地位

自2020年发布以来,NVIDIA A100持续占据高性能计算加速卡市场的主导地位。据统计,全球Top500超级计算机中有超过60%采用了A100加速卡,其在AI训练、数据中心计算等领域的市场份额长期保持领先。这一地位不仅源于其硬件性能的优势,更得益于英伟达完善的软件生态——包括CUDA编程模型、cuDNN深度学习库、TensorRT优化工具等,为开发者提供了从算法开发到部署的全流程支持。

值得一提的是,A100的能效比同样表现突出,其每瓦算力达到行业领先水平,在降低数据中心能耗的同时,满足了绿色计算的发展需求。随着AI和HPC技术的不断演进,A100仍在持续优化,衍生出 PCIe 版、SXM版等不同形态,进一步拓展了其应用边界。

而言,NVIDIA A100凭借强大的计算性能、先进的技术架构和完善的生态支持,成为高性能计算与AI领域的“标杆级”产品。无论是支撑科学研究的前沿探索,还是驱动人工智能的产业落地,A100都发挥着不可替代的作用,其技术创新也为后续加速卡的发展奠定了重要基础。