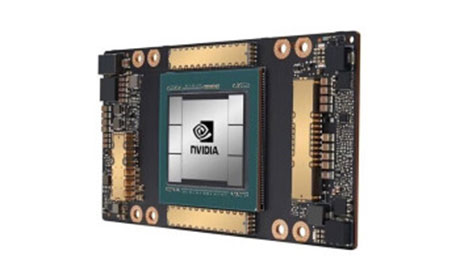

NVIDIA Tesla V100服务器,高效AI计算与深度学习的理想选择

概述:本文将深入解析NVIDIA Tesla V100服务器的核心性能、技术优势及应用场景,帮助读者全面了解这款在AI计算领域占据重要地位的硬件设备,为高效部署深度学习模型与科学计算任务提供参考。 N...

NVIDIA Tesla V100服务器的核心性能优势

作为NVIDIA基于Volta架构推出的旗舰级计算卡,Tesla V100服务器凭借突破性的硬件设计,成为AI训练与高性能计算的标杆产品。其搭载的Volta架构相比前代Pascal架构,在能效比、计算精度和并行处理能力上实现了显著提升。具体而言,V100服务器集成了5120个CUDA核心和64个Tensor Core,支持FP

16、FP

32、FP64等多种计算精度,其中FP16计算能力达到125 TFLOPS,FP64为13 TFLOPS,能够满足大规模深度学习模型(如Transformer、GAN)的训练需求。

在内存配置方面,V100服务器配备了16GB HBM2高带宽显存,带宽高达870 GB/s,相比传统GDDR5显存,大幅降低了数据交互延迟,有效避免计算资源闲置。同时,V100通过NVLink技术支持多卡互联,可实现单节点内GPU间的高速通信,进一步提升分布式计算效率,尤其适合超大规模集群部署。

广泛的适用场景与典型应用案例

NVIDIA Tesla V100服务器凭借卓越的计算性能,在多个领域展现出强大的应用价值。在人工智能领域,它是训练大语言模型(LLM)的关键硬件,如OpenAI的GPT系列模型、百度文心一言等,均依赖V100的高算力加速训练过程,缩短模型迭代周期。科学计算方面,V100可用于量子化学模拟、气候预测、流体力学等复杂计算任务,其Tensor Core能高效处理大规模矩阵运算,提升计算速度数倍。

在数据中心场景中,V100服务器常作为AI推理和高性能计算节点,支撑智能推荐、图像识别、自动驾驶等实时性需求。,电商平台通过V100服务器快速处理用户行为数据,实现精准推荐;科研机构利用V100进行基因测序数据分析,加速生命科学研究进展。V100服务器还适用于金融建模、工程仿真等对计算资源要求严苛的领域,成为企业数字化转型的核心算力引擎。

选购与优化建议:让V100服务器发挥最大效能

选择V100服务器时,需根据具体应用需求确定配置:若用于大规模AI训练,建议配置多卡NVLink互联;若以推理为主,可选择单卡或双卡配置。同时,需注意服务器的电源、散热系统是否匹配,确保V100芯片在高负载下稳定运行。在软件层面,及时更新NVIDIA驱动和CUDA Toolkit,可充分发挥V100的硬件性能;结合cuDNN、TensorRT等优化库,能进一步提升模型推理速度和精度。

对于已部署V100服务器的用户,可通过监控工具实时观察GPU利用率和内存使用情况,针对性调整任务调度策略;采用混合精度计算(如FP16/FP32),既能降低显存占用,又能保证计算精度,是平衡性能与成本的有效方法。定期进行硬件维护和系统更新,可延长V100服务器的使用寿命,降低长期使用成本。

而言,NVIDIA Tesla V100服务器凭借强大的计算能力、先进的架构设计和广泛的适配性,已成为AI计算与高性能计算领域的核心硬件。无论是企业级数据中心、科研机构还是开发者,选择V100服务器都能在高效处理复杂任务时获得显著优势,为人工智能和科学探索的突破提供坚实的算力支撑。