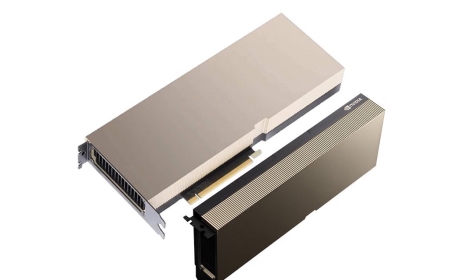

NVIDIA A100,AI训练与高性能计算的旗舰选择

概述:NVIDIA A100显卡作为数据中心领域的标杆级产品,凭借Ampere架构的创新与强大算力,成为AI训练、科学计算等场景的核心硬件。本文将从定位、技术优势及典型应用场景全面解析,展现其在高性能计...

一、NVIDIA A100的定位与技术背景

NVIDIA A100是面向企业级数据中心的旗舰GPU,基于台积电7nm工艺研发的Ampere架构,2020年正式发布后迅速成为AI训练与高性能计算(HPC)的行业标准。其核心目标是解决大规模数据处理与复杂模型训练的算力瓶颈,通过优化的架构设计与硬件配置,为云计算、科研、金融等领域提供高效算力支持。

二、核心技术与性能突破

A100的性能优势源于多维度技术创新。在计算架构上,采用新一代SM(流式多处理器)设计,每颗A100 GPU包含60个SM单元,每个单元集成64个CUDA核心,整体CUDA核心数量达54240个,单精度浮点性能(FP32)达19.5 TFLOPS,双精度(FP64)为9.7 TFLOPS,这一算力水平较前代Tesla V100提升约2倍。

针对AI场景,A100首次引入第三代Tensor Core,支持混合精度计算(FP16/FP8),AI算力(TF32)达1270 TFLOPS,BF16算力更是达到2010 TFLOPS,大幅提升深度学习模型训练效率。同时,A100配备40GB HBM2e高带宽显存,显存位宽1024-bit,带宽高达2TB/s,有效解决了AI训练中数据吞吐瓶颈,确保算力不被显存限制。

三、典型应用场景与市场影响

在AI训练领域,A100是大语言模型(如GPT-

A100成为云服务提供商(AWS、Azure、阿里云)构建AI云平台的关键组件,企业无需自建硬件集群即可按需调用其算力,降低了AI技术的应用门槛,加速了AI在电商推荐、智能医疗等行业的落地。尽管后续推出了H100等升级型号,但A100凭借优势性价比,至今仍是中高端AI与HPC场景的主流选择。

NVIDIA A100显卡以架构创新、强大算力与高带宽显存,成为AI训练与高性能计算的标杆产品。其技术理念不仅推动了数据中心算力升级,更通过云服务降低了技术应用门槛,为人工智能与科学研究的发展注入强劲动力,至今仍在市场中保持重要地位。