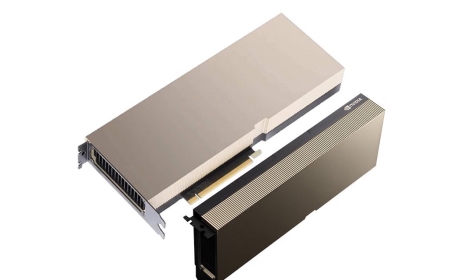

英伟达A100,性能参数详解

概述:本文将深入探讨英伟达A100显卡的各项参数,从架构、核心数量到内存、带宽,为您全面解析这款高性能计算GPU的卓越性能。通过本文,您将对A100的强大之处有更清晰的认识,了解其在人工智能、数据分析等...

英伟达A100架构解析

英伟达A100显卡采用了Ampere架构,这是英伟达在GPU技术上的一次重大飞跃。Ampere架构引入了第三代Tensor Core,使得AI计算性能得到显著提升。同时,A100还支持多实例GPU(MIG)技术,可以将单个GPU划分为多个独立的工作实例,从而提高资源利用率和灵活性。

A100核心数量与性能

A100拥有多达6912个CUDA核心和432个Tensor核心,这些核心协同工作,为各种计算任务提供强大的并行处理能力。CUDA核心负责通用计算,而Tensor核心则专门用于加速深度学习中的矩阵运算。这种核心配置使得A100在处理复杂的AI模型和大规模数据集时表现出色。

A100显存与带宽

A100配备了40GB或80GB HBM2e显存,提供高达1.6TB/s的显存带宽。大容量显存使得A100能够处理更大的数据集,而高带宽则保证了数据在GPU内部的快速传输。这对于需要频繁访问显存的应用来说至关重要,科学计算、金融建模等。

A100功耗与散热

A100的功耗高达400W,因此需要强大的散热系统来保证其稳定运行。英伟达通常会提供液冷或风冷解决方案,以满足不同应用场景的需求。在部署A100时,需要充分考虑散热问题,确保GPU能够长时间稳定工作。

A100的应用领域

英伟达A100显卡广泛应用于人工智能、数据分析、高性能计算等领域。在AI领域,A100可以加速深度学习模型的训练和推理,提高AI应用的性能和效率。在数据分析领域,A100可以处理大规模数据集,帮助用户发现隐藏在数据中的模式和规律。在高性能计算领域,A100可以加速科学计算、金融建模等任务,为科研和商业决策提供支持。

英伟达A100显卡以其强大的计算能力、大容量显存和高带宽,成为高性能计算领域的理想选择。无论是AI研究人员、数据科学家还是工程师,都可以借助A100来加速工作流程,提高效率,实现创新。