NVIDIA H100服务器配置,打造AI计算集群的核心基石

概述:本文将全面解析NVIDIA H100服务器的配置方案,涵盖硬件选型、系统优化及集群部署策略,帮助您构建顶级AI算力平台,释放千亿参数模型的训练潜能。 H100 GPU:AI算力的核心引擎 NV...

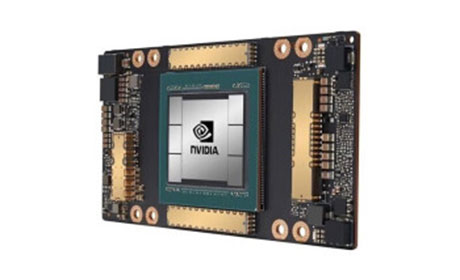

H100 GPU:AI算力的核心引擎

NVIDIA H100 Tensor Core GPU基于革命性的Hopper架构,配备18432个CUDA核心,支持第四代NVLink技术,单卡互连带宽达900GB/s。与A100相比,H100在大型语言模型训练中可实现9倍的加速效果。其80GB HBM3显存配合3.35TB/s的显存带宽,特别适合处理千亿参数级别的AI模型。服务器配置时需特别注意:每张H100 GPU需要搭配350W以上的独立供电模块,且推荐使用PCIe Gen5×16接口确保数据吞吐效率。

服务器硬件配置方案

AI服务器配置需统筹考虑三大核心组件:计算单元选用8卡HGX H100模组,CPU建议搭配双路第四代至强可扩展处理器(最低64核/128线程),内存配置需满足6TB DDR5 ECC REG。存储方面应选择双端口NVMe SSD阵列(最低30TB U.2固态),通过RAID10保障I/O性能。网络配置尤为关键,建议采用8×200Gb/s NVIDIA Quantum-2 InfiniBand,实现GPU间延迟低于1微秒的高速通信。机架部署需计算散热功率(单节点最大10kW),强制配置液冷散热系统。

集群架构优化实践

构建大规模H100计算集群时,采用分层架构:计算节点通过InfiniBand交换机构建Fat-Tree拓扑;采用NVIDIA Base Command Manager实现集群调度;存储节点配置并行文件系统(如Lustre/GPFS)。关键优化包括:启用GPUDirect RDMA技术绕过CPU内存拷贝;配置Magnum IO通信库优化AllReduce操作;使用多实例GPU技术(MIG)实现单卡七分割。通过NVIDIA DOCA软件框架,可发挥DPU卸载潜力,降低主机CPU负载达30%。

软件生态配置指南

系统层面建议安装Ubuntu 20.04 LTS或RHEL 8.6,配合NVIDIA H100专用驱动515.x以上版本。容器环境需配置最新版Docker和NVIDIA Container Toolkit。深度学习环境安装:CUDA Toolkit 12.0 + cuDNN 8.9 + NCCL 2.18组合。关键性能优化手段:开启Transformer Engine自动混合精度;配置CUDA Graphs减少内核启动开销;使用H100特有的DPX指令集加速动态编程算法。监控系统应集成DCGM和Prometheus+Grafana套件,实时追踪GPU利用率、显存占用及温度曲线。