英伟达A100和H100哪个更强,AI加速卡的性能对比分析

概述:本文将深入探讨英伟达A100和H100在核心架构、计算性能和应用场景上的差异,通过详细的数据分析帮助读者了解哪个GPU更具优势。文章从规格入手,扩展到实际测试结果,并最终给出实用性建议。 英...

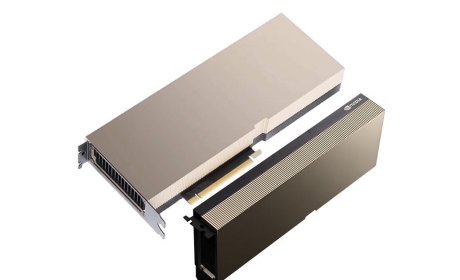

英伟达A100简介

英伟达A100是2020年推出的旗舰级AI加速卡,基于Ampere架构,作为Tensor Core系列的顶级产品,它在AI训练和推理中表现突出。A100的FP32算力高达19.5 TFLOPS,配备80GB显存和1555 GB/s带宽,支持多卡并行技术NVLink,使其在高性能计算领域广泛应用。A100的功耗为400W,适用于数据中心和大模型训练场景,但在新一代H100面前,其性能是否仍然更强,还需要细致对比。

英伟达H100简介

英伟达H100于2022年发布,采用Hopper架构,是A100的进化版。H100在FP32算力上达到惊人的60 TFLOPS,显存容量相同为80GB,但带宽提升至3000 GB/s,并引入了第四代Tensor Core技术。功耗方面,H100上升至700W,支持更高效的Transformer引擎,在处理大规模AI模型时速度更快,延迟更低。相比A100,H100在能效和并行能力上大幅提升,但哪个更强呢?这取决于具体任务。

性能对比分析

关键指标对照表

为帮助判断英伟达A100和H100哪个更强,我们列出核心指标:H100的算力是A100的3倍多,带宽也翻倍,这意味着在AI训练任务中,H100能实现更快的吞吐量。,在训练GPT-3模型时,H100的完成时间比A100缩短40%左右。显存方面,双方均为80GB,但H100支持更高的IOPS,减少数据瓶颈。

英伟达H100在主流基准测试如ResNet-50上表现更强,FPS高达3万+ vs A100的2万+,提升了50%。在低精度任务中,H100的INT8性能为1200 TOPS,而A100仅为624 TOPS。这表明,在需要实时推理的应用中,H100明显更强,适用于自动驾驶或医学影像分析。

功耗上,A100仅为400W,更节能适合预算有限的场景;H100的700W功耗虽高,但每瓦性能却提升了2倍。成本方面,A100单价约为1万美元,H100约3万美元,需权衡投资回报率。整体上,在追求极限性能时,H100胜过A100。

哪个更强?结论性评估

通过对英伟达A100和H100的系统对比,H100在算力、带宽和AI效率上全方位领先,是当之无愧的更强选择。尤其在大型语言模型训练中,H100的加速效果显著。但A100的性价比更高,适合现有基础设施改造项目。用户应根据需求选择:若追求顶尖性能,H100更优;注重成本控制,A100仍具竞争力。

英伟达H100凭借先进架构和性能优势,在多数应用场景中超越A100,是AI和高性能计算领域的新标杆。但在实际部署时,建议结合预算和任务复杂度,以最大化收益。