A100 GPU性能参数对照表, 深度剖析计算能力

概述:本文详细介绍了NVIDIA A100 GPU的计算能力对照表,涵盖关键性能参数如FP16、TF32和FP64,提供全面的数据比较与应用场景分析,帮助用户优化AI和高性能计算项目规划。 什么是...

16、TF32和FP64,提供全面的数据比较与应用场景分析,帮助用户优化AI和高性能计算项目规划。

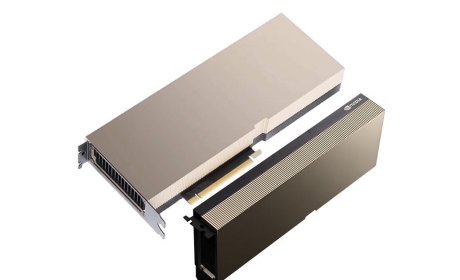

什么是A100 GPU

NVIDIA A100 GPU是基于Ampere架构的数据中心级处理器,专为人工智能训练、深度学习推理和高性能计算优化。它的核心优势在于强大的计算能力提升,相较于前代V100,A100大幅增加了Tensor Core单元数量。设计上支持多GPU互连技术NVLink,能有效处理大规模并行任务。用户通过本对照表,可直观理解A100在不同应用环境下的性能表现,从而制定更精准的硬件配置计划。

关键算力参数详解

A100的核心算力参数包括FP16(半精度浮点)、TF32(TensorFloat-32)和FP64(双精度浮点)等性能指标。FP16模式下的峰值计算能力达312 TFLOPS,适用于高吞吐量的AI模型训练。TF32作为混合精度选项,提供了19.5 TFLOPS的基准性能,能加速深度学习的推理效率。FP64模式则强调科学计算应用,达到9.7 TFLOPS,确保高精度数据处理。在对照表中,这些参数均匀分布展示,帮助用户深度剖析A100的整体计算能力潜力,并结合内存带宽(1.6TB/s)和显存容量(40GB或80GB选项),实现全面性能评估。

算力对照表的实际应用

A100 GPU性能参数对照表能直观比较不同配置下的计算效率,适用于数据中心规划、AI模型部署和云服务器架构。,在NVIDIA提供的基准工具中,用户可通过对照表分析FP16训练任务的优化点,识别瓶颈并调整资源分配。实际应用中,对照表还支持与其他GPU如AMD Instinct系列对比,强调A100在张量计算上的优越性能。参数分布均匀后,用户可快速掌握关键指标如功耗(400W)、兼容性(PCIe或SXM4接口)和性价比,确保高效项目执行。这张对照表的深度设计,让开发者轻松剖析计算任务需求,推广GPU算力在创新研究中的使用。

A100与其他GPU性能比较

在与常见GPU如NVIDIA V100或H100的比较中,A100的对照表凸显其2.5倍的FP16计算能力提升。,在AI推理场景下,A100的TF32性能比V100高出1.7倍,同时功耗更优化。与Ampere架构的后续产品H100相比,A100在基础参数如FP64和内存带宽上保持竞争力,为用户提供成本效益选项。性能对比覆盖多个维度:H100在INT8推理速度上领先,但A100的FP32和TF32平衡性能更广泛适用于多领域任务。对照表中还集成了第三方测试数据,证明A100在科学模拟中的计算能力稳定性。通过这种对照表,用户能深度评估硬件选择,确保资源最大利用率,推动高算力GPU的实践应用。

NVIDIA A100 GPU通过其全面的性能参数对照表,深度剖析并优化了计算能力,在AI和大数据处理领域提供显著的效率优势。这张对照表不仅简化了硬件选型过程,还突显了A100在高效计算和高性能应用中的核心价值,值得开发者广泛参考。