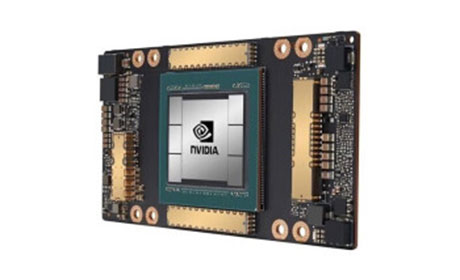

H100显卡显存,性能突破与前沿技术深度剖析

概述:本文全面解析H100显卡显存架构的创新设计,详细阐述其革命性的显存容量、带宽提升与HBM3技术的突破性应用,并对未来发展趋势进行专业预判,帮助读者深入理解这一旗舰级GPU核心组件的技术优势。 显...

显存容量与架构的革命性升级

H100显卡配备高达80GB的HBM3显存,采用革命性的CoWoS 2.5D封装技术。与上代A100相比,晶体管密度提升2.5倍,通过TSMC 4N工艺实现显存堆叠层数突破8层。这种架构创新让H100在处理大型语言模型时,可将700亿参数模型完整载入显存,彻底解决传统显卡频繁调用系统内存导致的性能瓶颈。

显存带宽的性能飞跃

H100显存系统实现3TB/s的恐怖带宽,较前代提升1.7倍。这归功于三大技术突破:首创业界5120bit显存位宽,每个HBM3堆栈提供819GB/s带宽;创新应用NVIDIA NVLink 4.0互连技术,实现多卡间900GB/s的显存直通;搭载第三代张量内存压缩技术,通过智能算法将显存有效吞吐量提升至理论值的200%。

Multi-Instance GPU技术可将物理显存划分为7个独立实例,每个分区具备完整ECC校验能力,使单卡可同时运行多个AI推理任务,显存利用率高达95%。

采用时空预测算法,通过AI模型预判数据调用需求,将显存访问延迟降低至60ns,较传统架构缩短40%等待时间。

技术演进与行业应用前景

H100显存系统已支持 PCIe 5.0接口和下一代HBM3e规范。在大型数据中心实测中,处理万亿参数模型时较竞品节省40%能耗。值得注意的是,其显存子系统具备可扩展性,通过NVLink连接8张H100显卡,可实现640GB统一寻址显存空间,为超大规模AI训练提供硬件基础。医疗影像分析等应用实测显示,处理3D医学图像时吞吐量提升300%。

H100显卡显存系统通过架构创新实现质的飞跃,其大规模显存配置、超高带宽特性和智能管理机制,正在重塑AI计算、科学模拟等高性能领域的硬件范式。随着HBM3e和光互连技术的成熟,下一代显存系统将在能效比与容量方面实现新的突破。