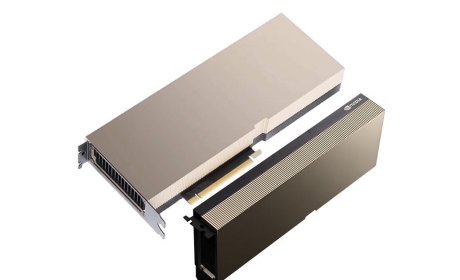

英伟达H200核心规格解析,全面解读架构性能升级

概述:作为英伟达Hopper架构的新旗舰,H200 GPU专为加速AI和高性能计算负载而设计,显著提升了显存带宽与容量,成为处理巨型AI模型和复杂科学仿真的利器。本文将深度剖析H200的关键规格参数。...

Hopper架构核心与计算性能

H200延续并强化了NVIDIA Hopper架构的创新设计:

- Tensor Core优化: 配备第四代Tensor Core,支持FP8精度及Transformer引擎加速,大幅提升LLM训练和推理效率,对比前代实现显著的AI算力增长。

- FP64高精度计算: 在科学计算领域表现卓越,提供强劲的双精度浮点性能,满足CAE仿真、气候建模等需求。

- 线程级并行增强: 改进的线程调度与执行单元,优化了并行任务处理能力。

革命性的显存子系统:HBM3e

H200最显著的升级在于显存:

- 超大显存容量: 提供高达141GB的HBM3e显存配置选项,是处理如GPT-

4、Llama 2等千亿参数级大模型的必备基础。 - 极致带宽突破: HBM3e显存带来惊人的4.8 TB/s峰值带宽,几乎是上一代H100对应版本(HBM3,3.35TB/s)的1.5倍,有效缓解了数据吞吐瓶颈。

- 能效提升: HBM3e技术在提供更高带宽的同时,也优化了单位数据传输的能耗。

高速互联与平台协同

互联能力是GPU集群扩展的关键:

- 第五代NVLink: 支持高达900GB/s的双向GPU间点对点带宽(NVLink 5.0),使多卡协同训练和推理达到前所未有的高效。

- PCIe Gen5 支持: 提供64GB/s的CPU-GPU互联带宽,确保与最新服务器平台的兼容性。

- NVSwitch 系统集成: 与NVSwitch系统无缝配合,构建强大的GPU计算节点和大规模AI集群。