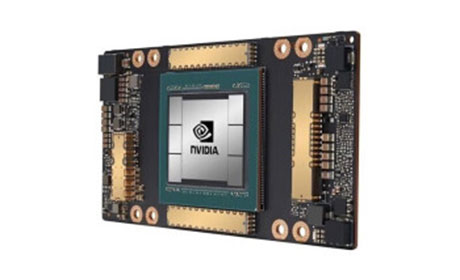

英伟达H200 高性能GPU,推动人工智能革命

概述:英伟达H200是NVIDIA最新推出的AI加速器GPU,专为高效能计算和深度学习设计。它在显存带宽、处理速度和能效上实现了显著突破,广泛应用于训练大规模语言模型和大数据分析等领域。本文将深入解析H...

英伟达H200的核心技术特性

英伟达H200基于改进的Hopper架构,配备高达188GB的HBM3e显存和4. 8TB /s带宽,比前代产品H100提升了1.5倍的AI训练速度。这款H200 GPU支持Transformer引擎优化,能够高效处理浮点运算和大规模数据集。英伟达在2023年11月正式发布H200后,它迅速成为AI模型的理想选择,包括对GPT-4等大型语言模型的加速训练。H200的设计注重能效比,在保持高性能的同时降低了能耗,使其在数据中心和云计算中优势明显。NVIDIA通过H200强化了其在AI计算领域的领导地位,满足企业对高效推理和训练的需求。

H200在AI深度学习中的性能表现

在AI应用中,英伟达H200展现了惊人的速度提升。,在Transformer模型训练中,H200减少了高达40%的延迟,显著缩短了迭代时间。GPU的强大并行处理能力允许快速执行深度学习算法,如图像识别和自然语言处理。英伟达H200的高显存容量支持复杂数据集加载,避免数据溢出问题,从而提升整体AI系统效率。各大机构已证实,使用H200的NVIDIA系统在BERT或ResNet模型上的表现优于传统GPU。AI计算得益于H200的优化结构,它能够无缝处理多线程任务,为研究人员和开发者提供灵活的平台。

英伟达H200的实际应用领域

英伟达H200已在多个行业落地,驱动了创新解决方案。在AI研究领域,谷歌云和微软Azure等巨头采用H200构建大规模模型训练平台,显著降低LLM开发成本。H200在科学计算中也大放异彩,如药物发现和天气预报中模拟复杂算法,NVIDIA的GPU优化了数据处理流程。在自动驾驶和金融风控系统中,H200的实时推理能力确保了高精度结果。英伟达与OpenAI合作,通过H200实现了GPT-5的预训练加速,彰显其在生成式AI中的关键作用。H200的部署不仅提升了企业效率,还推动了教育和个人开发者对AI工具的采用。

英伟达H200作为一款领先的GPU,不仅提升了AI计算性能,还重塑了多个行业的数字化进程。它在能效、速度和多功能性上的突破,使NVIDIA保持在技术前沿。未来,随着H200在更多场景的应用,它将继续定义AI时代的新标准,推动科学和商业创新的边界。