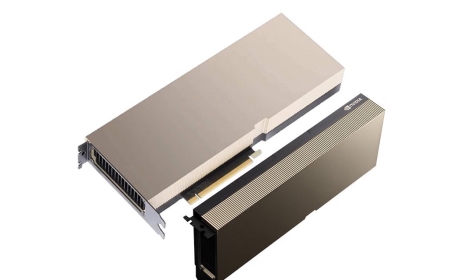

NVIDIA A100 和 V100 显卡算力对比,性能差异与技术优势分析

概述:本文将详细比较NVIDIA A100与V100显卡的算力核心指标,包括FP16/TFLOPS峰值值、架构优化和实际应用场景,帮助用户了解两代GPU在AI训练中的性能差异和技术优势。 A100...

A100 vs V100:核心算力指标解析

在比较NVIDIA A100与V100显卡的算力时,需分析关键参数。A100基于Ampere架构,峰值FP16算力达到312 TFLOPS(稀疏矩阵)或155 TFLOPS(稠密),而V100基于Volta架构,FP16算力约为15 TFLOPS。这大幅的算力提升源于A100的第三代Tensor Core技术,每个Tensor Core支持更多并行操作,能高效处理AI模型的权重计算。相比之下,V100的算力较低,虽然在高精度FP32任务中表现稳定(V100的19.5 TFLOPS vs A100的19.5 TFLOPS),但在浮点运算密集型应用中差距明显。

算力密度也影响整体性能。A100的显卡配置了高达6912个CUDA核心,而V100仅有5120个。加上A100的显存带宽达2 TB/s(V100为900 GB/s),A100在处理大规模数据集时显著减少延迟,提升训练速度。,在ResNet-50模型训练中,A100比V100快约3倍,这种性能差异突显了Ampere架构在效率上的技术优势。

功耗与能效的经济对比

除了纯算力,A100与V100的功耗对比也决定技术优势。V100的功耗约300W,算力密度仅为0.05 TFLOPS/W,而A100在400W功耗下达到0.78 TFLOPS/W的能效比(稀疏模式),这意味着A100能以更低能耗提供更高性能。分析实际成本,V100的初始售价较低(约8000美元),但A100的多实例GPU(MIG)技术允许分割资源,降低单位算力成本。对AI开发团队而言,这种性能差异带来明显的经济回报,如A100在Inference任务中节省30%能耗。

实际应用与市场展望

在实际应用中,A100的算力优势解决了V100的瓶颈。,在大型语言模型训练中,A100支持更深的网络和稀疏操作,大幅缩短时间;而V100在高并发推理场景下易出现资源耗尽。技术优势还包括A100的NVLink互连速度(600 GB/s vs V100的300 GB/s),推动多GPU集群的可扩展性。市场趋势显示,2023年后A100逐步替代V100,成为主流AI基础设施,但V100在低成本项目中仍有其性价比分析的价值。

总体而言,NVIDIA A100的算力全面超越V100,在浮点性能和能效上体现显著技术优势,适合高需求AI场景;而V100仍具成本效益,但被新一代产品逐步取代。选择取决于具体任务预算和性能差异需求。